ETSIレポートは、AIセキュリティを標準化するための道を開きます

電気通信、放送、電子通信のネットワークとサービスに関するヨーロッパの標準化団体であるETSIからの新しいレポートは、人工知能(AI)セキュリティの標準を確立するための道を開くことを目的としています。

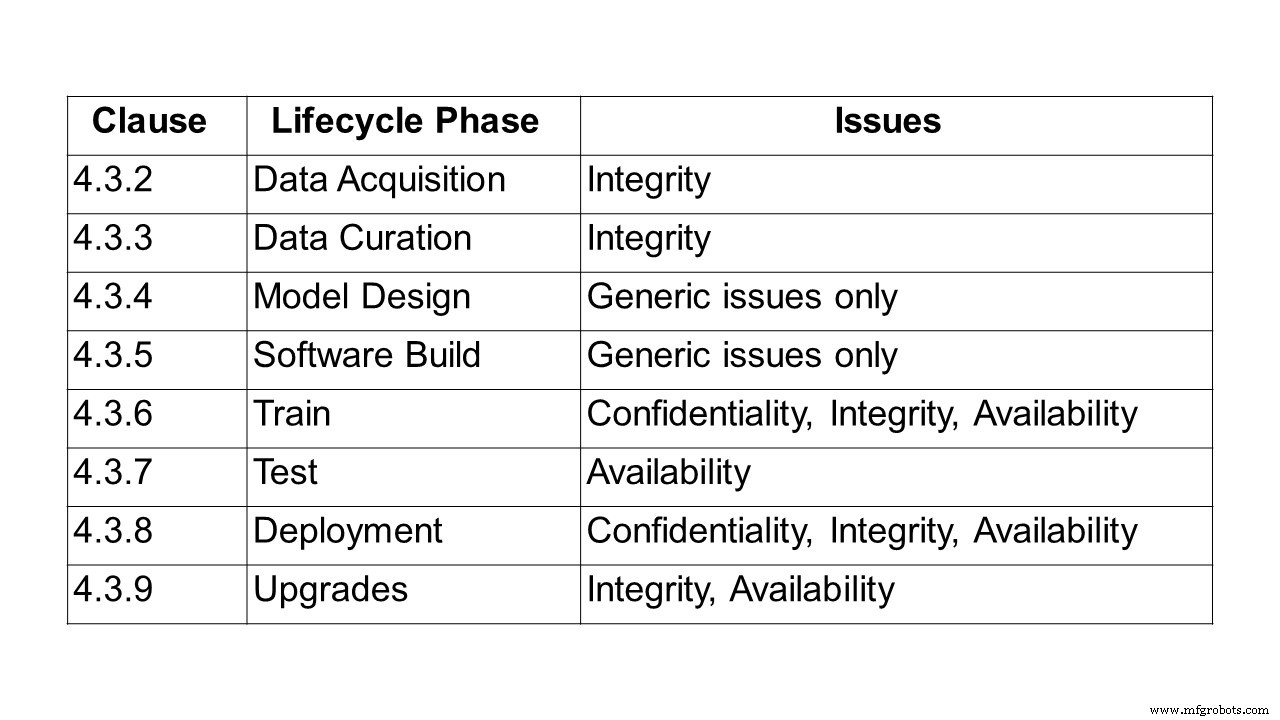

標準を作成するための最初のステップは、AIベースのシステムとソリューションを保護する問題を説明することです。これは、ETSI Securing Artificial Intelligence Industry Specification Group(SAI ISG)によって最初に発行された24ページのレポートETSI GR SAI004が行うことです。問題の説明を定義し、機械学習(ML)と、機械学習ライフサイクルの各段階での機密性、整合性、可用性に関連する課題に特に焦点を当てています。また、偏見、倫理、説明能力など、AIシステムの幅広い課題のいくつかを指摘しています。さまざまな攻撃ベクトルの概要と、実際の使用および攻撃のいくつかのケースが概説されています。

AIの保護に関連する問題を特定するための最初のステップは、AIを定義することでした。 ETSIグループにとって、人工知能とは、明示的および暗黙的な表現を処理するシステムの機能であり、人間が実行した場合にインテリジェントと見なされるタスクを実行する手順です。この定義は、依然として幅広い可能性を表しています。ただし、主に機械学習と深層学習の技術の進化、およびそのような技術のトレーニングと実装に必要なデータと処理能力の幅広い可用性によって、限られた一連の技術が実現可能になりつつあります。

教師あり学習、教師なし学習、半教師あり学習、強化学習など、機械学習への多数のアプローチが一般的に使用されています。

- 教師あり学習–すべてのトレーニングデータにラベルが付けられ、新しい入力セットに基づいて出力を予測するようにモデルをトレーニングできます。

- 半教師あり学習–データセットに部分的にラベルが付けられています。この場合、ラベルのないデータでもモデルの品質を向上させるために使用できます。

- 教師なし学習–データセットにラベルが付けられておらず、モデルがグループ化やクラスタリングなど、データ内の構造を探します。

- 強化学習–行動の仕方を定義するポリシーが、エージェントが報酬を最大化するための経験を通じて学習する場合。エージェントは、状態の遷移を通じて環境内で対話することで経験を積みます。

これらのパラダイム内では、さまざまなモデル構造が使用される可能性があります。最も一般的なアプローチの1つは、人間の脳の動作を模倣する一連の階層層で学習が実行されるディープニューラルネットワークの使用です。

さまざまなトレーニング手法、つまり敵対的学習も使用できます。このトレーニングセットには、望ましい結果を反映するサンプルだけでなく、期待される行動に挑戦したり混乱させたりすることを目的とした敵対的サンプルも含まれます。

「AIの倫理については多くの議論がありますが、AIの保護に関する基準については議論されていません。それでも、AIベースの自動ネットワークのセキュリティを確保するためにそれらは重要になりつつあります。この最初のETSIレポートは、AIを保護するときに直面する課題の包括的な定義を作成することを目的としています。並行して、脅威オントロジー、AIデータサプライチェーンを保護する方法、およびそれをテストする方法に取り組んでいます」と、ETSI SAIISGの議長であるAlexLeadbeaterは説明します。

タイムラインについて尋ねられたLeadbeaterは、embedded.comに次のように語っています。今後数四半期にわたって、さらに多くのテクニカルレポートが発表されます(AI脅威オントロジー、データサプライチェーンレポート、SAI緩和戦略レポート)。実際、AIのセキュリティテストに関する1つの仕様は、第2四半期と第3四半期の終わり頃に発表されるはずです。次のステップは、より詳細な有益な作業項目に拡張できる問題ステートメントの特定の領域を特定することです。」

レポートの概要

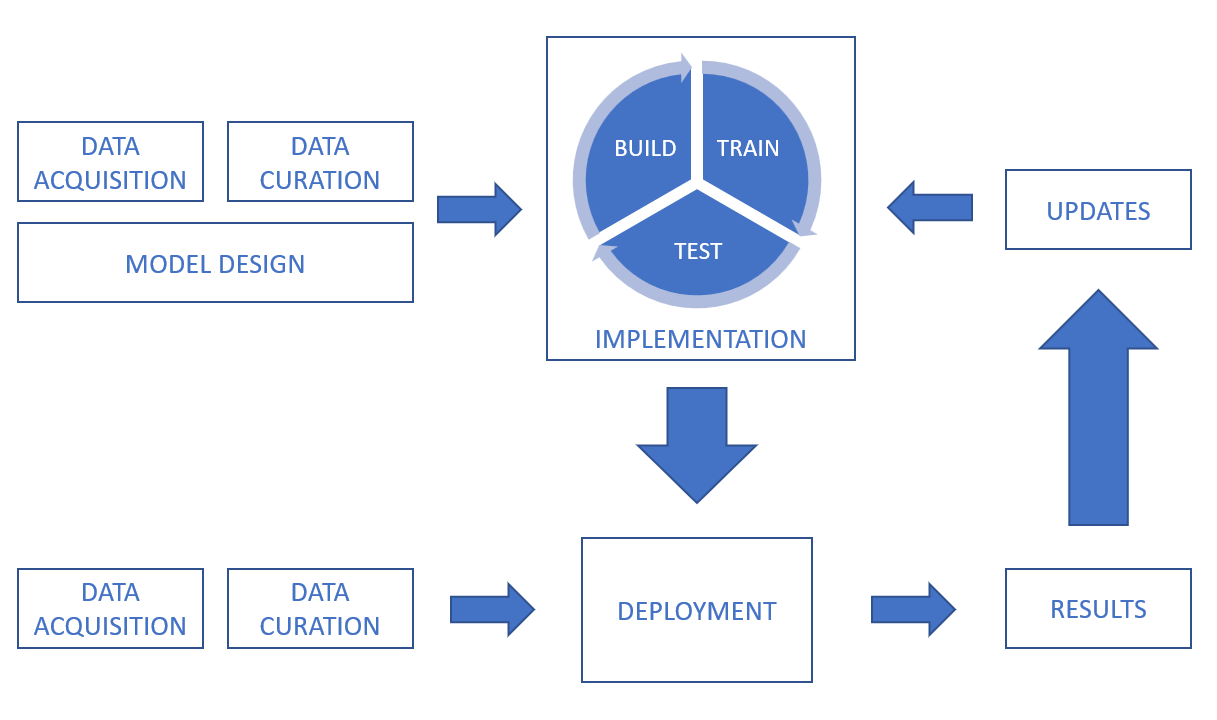

AIと機械学習の定義に続いて、レポートはデータ処理チェーンを調べ、データ取得、データキュレーション、モデル設計、ソフトウェアビルドからトレーニング、テスト、展開、推論、およびアップグレード。

AIシステムでは、センサー(CCTVカメラ、携帯電話、医療機器など)やデジタル資産(取引プラットフォーム、ドキュメント抽出、ログファイルなど)を含む多数のソースからデータを取得できます。データは、さまざまな形式(テキスト、画像、ビデオ、オーディオなど)にすることもでき、構造化または非構造化することもできます。データ自体に関連するセキュリティの課題に加えて、送信とストレージのセキュリティを考慮することが重要です。

データセットを修復、拡張、または変換するときに、データキュレーションにおける整合性の課題を示すには、プロセスがデータの品質と整合性に影響を与えるリスクがないことを確認することが重要です。教師あり機械学習システムの場合、データのラベル付けが正確で可能な限り完全であり、ラベル付けがその整合性を維持し、中毒攻撃などによって危険にさらされないようにすることが重要です。データセットに偏りがないことを確認するという課題に取り組むことも重要です。データ拡張の手法は、データの整合性に影響を与える可能性があります。

対象となるもう1つの分野は、バイアス、データ倫理、説明可能性に関する他の意図しない要因に関する設計上の課題です。

たとえば、バイアスは設計段階とトレーニング段階の間だけでなく、システムが展開された後も、バイアスが導入される可能性があるため、考慮する必要があります。レポートは、「会話理解」の実験として意図されたチャットボットが立ち上げられた2016年の例を引用しています。チャットボットは、ツイートやダイレクトメッセージを通じてソーシャルネットワークユーザーと交流します。数時間のうちに、チャットボットは非常に不快なメッセージをツイートし始めました。チャットボットが撤回された後、チャットボットのアカウントがインターネットの荒らしによって偏った行動を表示するように操作されていたことが発見されました。バイアスは必ずしもセキュリティの問題を表すわけではありませんが、システムがその機能要件を満たさなくなる可能性があります。

倫理に関しては、レポートは自動運転車やヘルスケアを含むいくつかの例を強調しています。ブライトン大学の論文を引用しており、AIを搭載した車が歩行者をノックダウンし、その後の法的責任を調査するという架空のシナリオについて説明しています。 2018年3月、アリゾナ州テンペ市で自動運転車が歩行者を殴り殺したときに、このシナリオが現実のものとなりました。これにより、法的責任だけでなく、意思決定プロセス自体の潜在的な倫理的課題にも焦点が当てられました。 2016年、マサチューセッツ工科大学(MIT)は、インテリジェントシステムが倫理的な性質の意思決定を行えるようにするという課題を調査するMoralMachineというWebサイトを立ち上げました。このサイトは、倫理的なジレンマに直面したときに人間がどのように行動するかを調査し、機械がどのように行動すべきかをよりよく理解しようとしています。

レポートは、倫理的な懸念が機密性、整合性、可用性という従来のセキュリティ特性に直接関係しない一方で、システムが信頼できるかどうかの個人の認識に大きな影響を与える可能性があることを強調しています。したがって、AIシステムの設計者と実装者は、倫理的な課題を検討し、ユーザー間の信頼を築くことができる堅牢な倫理システムの作成を模索することが不可欠です。

最後に、レポートでは、ポイズニングやバックドア攻撃からリバースエンジニアリングまで、実際のユースケースと攻撃に続く攻撃の種類について説明します。

ポイズニング攻撃では、攻撃者は通常トレーニングフェーズ中にAIモデルを侵害しようとします。これにより、デプロイされたモデルは攻撃者が望むように動作します。これは、特定のタスクまたは入力に基づいてモデルが失敗したか、モデルが攻撃者にとって望ましいがモデル設計者が意図していない一連の動作を学習したことが原因である可能性があります。中毒攻撃は通常、次の3つの方法で発生する可能性があります。

- データ中毒 –攻撃者が、データ収集またはデータキュレーションの段階で、誤った、または誤ったラベルのデータをデータセットに導入する場合。

- アルゴリズム中毒 –攻撃者が学習プロセスに使用されるアルゴリズムに干渉した場合。たとえば、連合学習では、データのサブセットについて個々のモデルをトレーニングし、学習したモデルを組み合わせて最終的なモデルを形成します。これは、個々のデータセットはプライベートのままですが、固有の脆弱性を生み出すことを意味します。攻撃者は個々のデータセットを制御できるため、学習モデルのその部分を直接操作して、システムの全体的な学習に影響を与える可能性があります。

- モデル中毒 –デプロイされたモデル全体が単に代替モデルに置き換えられた場合。このタイプの攻撃は、モデルを構成する電子ファイルが変更または置換される可能性がある従来のサイバー攻撃に似ています。

「人工知能」という用語は、1950年代に米国ニューハンプシャー州ハノーバーのダートマス大学で開催された会議で生まれましたが、ETSIレポートに記載されている実際の使用例は、それ以降にどれだけ進化したかを示しています。このようなケースには、広告ブロッカー攻撃、マルウェアの難読化、ディープフェイク、手書きの複製、人間の声、偽の会話(チャットボットですでに多くのコメントが寄せられています)が含まれます。

次は何ですか?このISGの一部として進行中のレポート

この業界仕様グループ(ISG)は、その下の作業項目の一部として、いくつかの進行中のレポートを検討しています。

セキュリティテスト :この作業項目の目的は、AIベースのコンポーネントのセキュリティテストに適した目的、方法、および手法を特定することです。全体的な目標は、シンボリックAIとサブシンボリックAIのさまざまなアルゴリズムを考慮し、ワークアイテム「AI脅威オントロジー」からの関連する脅威に対処する、AIおよびAIベースのコンポーネントのセキュリティテストのガイドラインを作成することです。 AIのセキュリティテストには、従来のシステムのセキュリティテストといくつかの共通点がありますが、

により、新しい課題が発生し、さまざまなアプローチが必要になります。(a)シンボリックおよびサブシンボリックAIと、セキュリティおよびセキュリティプロパティのテスト方法に強い影響を与える従来のシステムとの大きな違い。

(b)AIベースのシステムは時間の経過とともに進化する可能性があり(自己学習システム)、セキュリティ特性が低下する可能性があるため、非決定論。

(c)テストオラクルの問題、テスト評決の割り当ては、AIベースのシステムでは異なり、より困難です。これは、期待されるすべての結果が事前にわかっているわけではないためです。(d)データ駆動型アルゴリズム:従来のシステムとは対照的に、(トレーニング)データサブシンボリックAIの動作を形成します。

セキュリティテストに関するこの作業項目の範囲は、次のトピックをカバーすることです(ただしこれらに限定されません)。

- AIのセキュリティテストアプローチ

- セキュリティの観点からAIのデータをテストする

- AIのセキュリティテストオラクル

- AIのセキュリティテストのテスト妥当性基準の定義

- AIのセキュリティ属性のテスト目標

また、上記のトピックを考慮したAIのセキュリティテストのガイドラインを提供します。ガイドラインでは、ワークアイテム「AI Threat Ontology」の結果を使用して、セキュリティテストを通じてAIに関連する脅威をカバーし、AIベースのシステムをテストする際の課題と制限にも対処します。

AI脅威オントロジー :この作業項目の目的は、AIの脅威と見なされるものと、それが従来のシステムに対する脅威とどのように異なるかを定義することです。この作業の理論的根拠を提供する出発点は、現在、AIに対する攻撃を構成するものと、AIがどのように作成、ホスト、および伝播されるかについての一般的な理解がないということです。 「AI脅威オントロジー」の成果物は、さまざまな利害関係者や複数の業界にわたって用語を調整することを目的としています。このドキュメントでは、サイバーセキュリティと物理的セキュリティのコンテキストでこれらの用語が何を意味するのかを定義し、複数の業界の専門家と知識の少ない聴衆の両方がすぐにアクセスできるようにする必要がある説明を添えます。この脅威オントロジーは、AIをシステム、敵対的な攻撃者、およびシステム防御者として扱うことに注意してください。

データサプライチェーンレポート :データはAIシステムの開発における重要なコンポーネントです。これには、生データだけでなく、ループ内の他のシステムや人間からの情報やフィードバックも含まれます。これらはすべて、AIのトレーニングと再トレーニングによってシステムの機能を変更するために使用できます。ただし、適切なデータへのアクセスが制限されることが多く、適切でないデータソースに頼る必要があります。トレーニングデータの整合性を損なうことは、AIシステムに対する実行可能な攻撃ベクトルであることが実証されています。これは、データのサプライチェーンを保護することが、AIを保護するための重要なステップであることを意味します。このレポートでは、AIをトレーニングするためのデータを調達するために現在使用されている方法と、そのデータの処理と共有を制御できる規制、標準、プロトコルをまとめています。次に、この情報のギャップ分析を提供して、データのトレーサビリティと整合性、関連する属性、情報、フィードバック、およびこれらの機密性を確保するための標準の可能な要件を調査します。

SAI緩和戦略 レポート:この作業項目は、AIベースのシステムの脅威に対する既存および潜在的な緩和策を要約および分析することを目的としています。目標は、システムにAIを採用することによってもたらされる脅威を軽減するためのガイドラインを用意することです。これらのガイドラインは、既知または潜在的なセキュリティの脅威を軽減することにより、AIベースのシステムを保護するためのベースラインを明らかにします。また、特定の潜在的なユースケースでAIベースのシステムの緩和策を採用する際のセキュリティ機能、課題、および制限にも対処します。

? AIのセキュリティにおけるハードウェアの役割: AIのセキュリティにおける、特殊なものと汎用的なものの両方のハードウェアの役割を特定するレポートを作成する。これにより、攻撃を防ぐためにハードウェアで利用可能な緩和策に対処し、SAIをサポートするためのハードウェアの一般的な要件にも対処します。さらに、このレポートでは、ハードウェアの保護にAIを使用するための可能な戦略について説明します。レポートは、AIのハードウェアセキュリティにおける学術的および産業的経験の要約も提供します。さらに、このレポートでは、AIへの攻撃ベクトルを増幅する可能性のあるハードウェアによってもたらされる脆弱性や弱点についても取り上げます。

AIを保護するための問題ステートメントを定義する完全なETSIレポートはこちらから入手できます。

モノのインターネットテクノロジー

- 2020年のIIoTセキュリティのヒントとトレンド

- 産業用セキュリティのレシピ:ITのダッシュ、OTのピンチ、SOCの振りかけ

- ユニバーサルIoTセキュリティ標準の検索

- TI:BAW共振器テクノロジーは、次世代通信への道を開きます

- クラウドビジネスユーザー向けに発行されたサイバーセキュリティガイド

- 重要なインフラストラクチャに対するサイバー脅威に対応するための緊急アクションの必要性を報告する

- グローバルIoTセキュリティの3つのステップ

- IoTデバイスのセキュリティ保証に関する4つのステップガイド

- 5Gの登場がIoTセキュリティにとって何を意味するか

- FTCの「MadeinUSA」は、追加の執行に対する罰則の道を開く

- サイバー資産レポートの状態はまだ脆弱性を見つけています