機械学習ベンチマークは、エッジ、データセンターのワークロードのサポートを拡張します

ベンチマーク組織であるMLCommonsは、MLPerf推論スコアの新しいラウンドをリリースしました。この最新のラウンドは、比較を容易にするためにデバイスのクラスに分けられています。この結果には、さまざまな新しいAIモデルも含まれています。これらのモデルは、商業的に展開されているものの、依然として最先端と見なされているさまざまなワークロードを表すことを目的としています。

Nvidiaで高速化されたシステムは、提出全体の約85%を占め、入力したすべてのカテゴリを獲得しました。ただし、モバイルクラスまたはノートブッククラスにはNvidiaの提出はありませんでした(NvidiaはAIアクセラレータ製品を備えたこれらの市場には存在しません)。スタートアップからの興味深い投稿もいくつかあり、全体的に複数の列に数字が表示される傾向が強く、比較が容易になっています。

前回のラウンドからの変更

このラウンドの結果に対する最初の大きな変更は、システムがデータセンター、エッジ、モバイル、ノートブックのクラスに分離されたことです。携帯電話とノートブックには、非常に特殊なフォームファクタとパフォーマンスプロファイルがあり、幅広いエッジリストから簡単に分離できます。

「ノートブックについて話している場合は、おそらくWindowsを実行しています。スマートフォンについて話している場合は、おそらくiOSまたはAndroidを実行しています」と、MLCommonsのエグゼクティブディレクターであるDavidKanter氏は EE Times > 。 「これらの結果を推論スコアのより大きなプールから分離することは、物事をより明確にするのに非常に役立ちます。」

この第2ラウンドの推論スコアのベンチマークも改良され、最新のユースケースを表すAIモデルが含まれるようになりました。前回のラウンドでは視覚と画像処理モデルに焦点を当てていましたが、今回のデータセンターとエッジクラスには、推奨モデルDLRM、MRIスキャンで腫瘍を探すために使用される医用画像モデル3D-UNet、音声テキストモデルRNN-が含まれます。 Tおよび自然言語処理(NLP)モデルBERT。

「[モデルの選択]は顧客の意見に基づいていますが、学生に独自のテストを設定させるという罠にはまりたくありません」とカンター氏は述べ、生産中の最先端モデルを特定することが目的であると説明しました。研究段階だけではありません。 「DLRMと3D-UNet、それらは私たちの諮問委員会、医学界の人々、大規模な推奨を行う人々によって推進される非常に情報に基づいた[選択]でした…そのような情報に基づくワークロードの構築は非常に価値があります。」

モバイルクラスとノートブッククラスは、画像分類にMobileNetEdge、オブジェクト検出にSSD-MobileNetv2、画像セグメンテーションにDeeplabv3、NLPにMobileBERTを使用します。

全体的に、実際の展開を反映するために、精度の目標も引き上げられました。

以下の分析は、公正な比較のために「クローズド」部門のみを参照しています。

データセンターの結果

予想どおり、データセンタークラスの提出物の大部分はNvidiaGPUアクセラレーターを使用していました。残りは、いくつかの例外を除いて、AI処理にIntel CPUを使用しました(以下を参照)。今回のTPUに対するGoogleからの提出はなく、この分野での地位を確立しているスタートアップのボーカルコミュニティ(Graphcore、Cerebras、Groqなど)からの提出もありません。

「CPUに対する[Nvidia]のパフォーマンスリードは、ResNetと呼ばれる基本的なコンピュータービジョンモデルと高度なレコメンデーションシステムモデルで約6倍から30倍に向上しました... NvidiaA100は[Intel]のCooperLakeCPUより237倍高速です」とPareshKharya氏は述べています。 、Nvidiaの製品管理およびマーケティングのシニアディレクター。 「単一のDGX-A100は、レコメンデーションシステムで1000 CPUサーバーと同じパフォーマンスを提供し、顧客にとって驚異的な価値を提供します。」

Mipsologyは、この部門で唯一市販されている非CPU非GPU参入企業でした。同社には、ザイリンクスFPGA(この場合はザイリンクスAlveo U250)で動作するZebraと呼ばれるアクセラレータテクノロジがあります。彼らのテクノロジーは、サーバーモードで1秒あたり4096のResNetクエリ(Nvidia T4の約5563と比較)またはオフラインモードで1秒あたり5011のサンプル(Nvidia T4の約6112と比較)を処理できます。

台湾の企業Neuchipsは、研究、開発、または内部カテゴリにスコアを提出しました。これは、使用したデバイスが市販されておらず、少なくともあと6か月は使用されない可能性が高いことを意味します。 RecAccelは、このベンチマークで使用される推奨モデルであるDLRMを高速化するように特別に設計されています。 AI推論のためにIntelStratixFPGAで実行される大規模並列設計を使用します。 DRLMカテゴリでの結果は、Intel Cooper Lake CPUと同等かそれよりも悪く、Nvidiaとは一致しませんでした。

エッジの結果

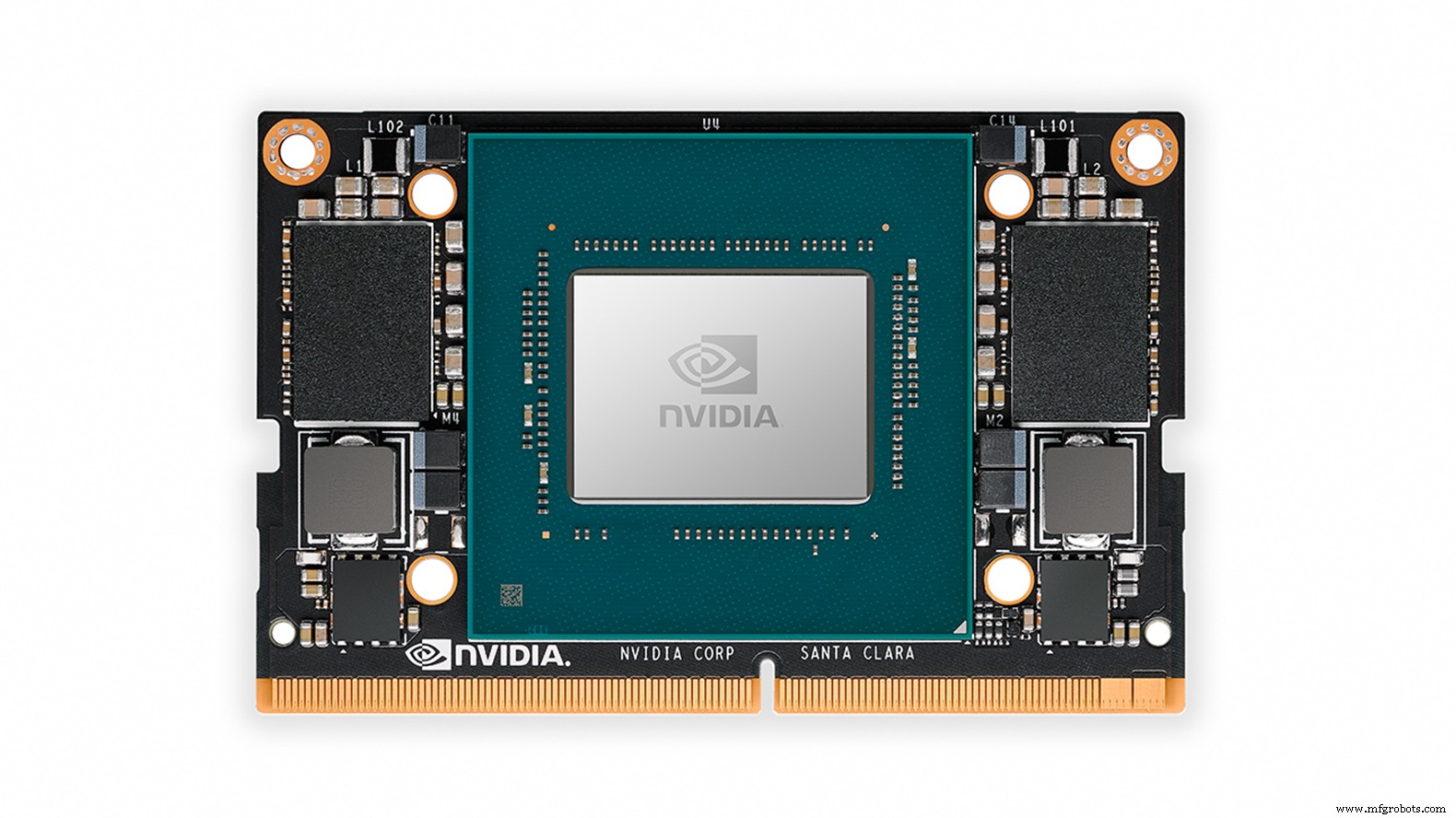

エッジカテゴリは、NvidiaのA100、T4、AGX Xavier、XavierNXによって加速されたスコアによって支配されていました。

Centaur Technologyは、社内のx86マイクロアーキテクチャに基づくCentaurのサーバープロセッサと、コプロセッサとしての独立した社内AIアクセラレータを使用する市販のリファレンスデザインシステムから成果を上げました。 Centaurによると、このリファレンスデザインは、オンプレミスまたはプライベートデータセンターアプリケーション向けのサーバークラスのシステムであり、(電力消費やピークパフォーマンスではなく)コストとフォームファクターに合わせて最適化されています。

ResNet画像分類(単一ストリーム遅延)では、Centaurのシステムは、TeslaT4を搭載したサーバーシステムに対するNvidia自身の提出よりも高速でした。ただし、T4は、1秒あたりに処理されるResNetオフラインサンプルでCentaurの設計を上回りました。ただし、Centaurは、Nvidiaの2つの組み込みエッジモジュールであるXavierNXとAGXXavierの間のどこかにあるため、オブジェクト検出についてはあまりうまくいきませんでした。

MLハードウェアおよびソフトウェアシステムを客観的に評価することを専門とする英国のエンジニアリングコンサルタント部門は、FireflysやRaspberryPisからNvidiaAGXXavierに至るまでのシステムで多数のスコアを提出しました。 Raspberry Piエントリのスコアは同じように見えますが、実際には異なるオペレーティングシステムを使用しています(32ビットDebianと64ビットUbuntu – Ubuntuは約20%高速でした)。 NvidiaはAGXXavierのGPUと2つのオンチップディープラーニングアクセラレータの両方をResNetオフラインスコアとマルチストリームスコアに使用し、dividitiはGPUのみを使用したため、同社の結果はAGXXavierに対するNvidia自身の結果とは異なりました。

ディビディティのスポークスマンも EE Times 同社は前回の推論ラウンドでNvidiaのスコアを「多かれ少なかれ」再現できましたが、最新の結果により、テストハーネスにパフォーマンスの低下が生じました。これは、提出期限の数分前にのみ認識されました(この間違いを修正すると、後で一部のレイテンシが改善されました。 10〜20%)。これは、結果に対するハードウェアとソフトウェアの組み合わせの重要性を説明するのに役立ちます。

エッジカテゴリは、Jetson Xavier NX(画像:Nvidia)を含むNvidiaGPUによって加速された結果によって支配されていました

このカテゴリの新しいエントリには、研究、開発、または内部カテゴリの両方のIVATechnologiesとMobilintが含まれます。

ロシアのIT機器の設計者および製造業者であるIVATechnologiesは、畳み込み、3D畳み込み、およびLSTMモデルをサポートするAIアクセラレータチップに取り組んでいます。同社は、FPGAに実装されたアクセラレータASICのプロトタイプである可能性がある「FPGA」というラベルの付いたスコアを提出しました。 ResNetのシングルストリームレイテンシは12.23ミリ秒で、Xavier NXの約4倍遅く、1秒あたり89のオフラインサンプルを処理しました。これはXavierNXの10分の1未満です。ただし、エッジカテゴリは広く、デザインについてはあまり知られていません。XavierNXよりも小型のデバイスを対象としている可能性があります。

韓国のAIアクセラレータASICスタートアップであるMobilintは、MobilintEdgeデザインのスコアを提出しました。 EETimes 容疑者は、ザイリンクスAlveo U250FPGAカードにプロトタイプとして実装されました。 ResNetでは、レイテンシはIVA Technologiesの設計よりもはるかに長く37.46ミリ秒でしたが、1秒あたりにより多くのオフラインサンプルを処理しました(107)。同社はまた、オブジェクト検出のスコアを提出しました。

IVA TechnologiesもMobilintも画期的なスコアを出していませんが、付随するソフトウェアスタックの準備ができていることを証明するため、プロトタイプのベンチマークには確かに価値があります。

モバイルの結果

新しいモバイルSoCカテゴリでは、明確な勝者がなく、かなり一致した3つの提出物がありました。

MediaTekは、Dimensity 820(Xiaomi Redmi 10X 5Gスマートフォン)のスコアを提出しました。このデバイスは、MediaTek独自のAIプロセッシングユニット(APU)3.0を使用します。これは、カメラ/イメージング機能用に最適化されたFP16およびINT16対応のアクセラレータです。 SoCには5コアGPUもあります。

Qualcomm Snapdragon 865+は、Adreno 650 GPUとともに、15TOPSでクロックインするAIアクセラレーション用に設計された同社のHexagon698プロセッサを使用しています。ベンチマークはAsusROG Phone3で実行されました。

SamsungのExynos990は、Galaxy Note 20Ultraの一部としてベンチマークされました。このデバイスには、デュアルコアNPU(ニューラルプロセッシングユニット)とArm Mali-G77 GPUが、さまざまなArmCPUコアとともに含まれています。

SamsungのExynos990は、画像分類とNLPで最高のパフォーマンスを発揮しました。 MediaTek Dimensity 820は画像分類に非常に近いものでしたが、SamsungはNLPでより明確なリードを持っていました。 MediaTekは、Qualcomm Snapdragon 865+が2位で、オブジェクト検出で明確なリードを持っていました。 MediaTekはまた、クアルコムをわずかに上回り、画像セグメンテーションベンチマークを獲得しました。

ノートブックの結果

ノートブックカテゴリには、次のIntel Xe-LPGPUをアクセラレータとして使用するIntelリファレンスデザインのエントリが1つだけありました。 Xe-LPは、データセンターのAIアクセラレーションおよびHPC用のXe-HPおよびXe-HPCの低電力バージョンです。どちらの大きなデバイスもベンチマークされていません。

このクラスにはエントリが1つしかないため、Xe-LPの結果を解釈するのは難しいです。ただし、ノートブックのカテゴリはモバイルのカテゴリと同じAIモデルを使用しているため、ある程度の比較は避けられません。 Xe-LPのモバイルSoCに対する最大の利点は、画像セグメンテーション(DeeplabV3)であり、スループット(フレーム/秒)でモバイルの勝者を2.5倍上回りました。その最も弱いパフォーマンスは、オブジェクト検出(SSD – MobileNetv2)であり、スループット(1秒あたりのフレーム数)の点でモバイルの勝者の1.15倍でした。

将来のベンチマーク

今後、Kanterは、ベンチマークの将来のラウンドに、NvidiaおよびIntel以外のCPUエントリがさらに含まれることを期待しており、組織は新興企業や中小企業に結果の提出を奨励していると述べています。

「私たちはオープンな部門を持っており、あなたが望むどんなネットワークでも提出することができます」と彼は言いました。 「それの良いところの1つは、顧客がXが欲しいと言って、それをすべて有効にした場合、コードをドロップして実行内容を確認できる限り、Xを使用できることです。 」

企業は、エンジニアリングの労力を低く抑えるために、わずか1つのAIモデルの結果を送信できます。また、独自のモデルをオープンカテゴリに送信することもできます。

Kanterはまた、次のスコアラウンドに電力測定ディメンションを導入することが組織の意図であると述べました。作業はすでに進行中です。

「私たちが人々に参加してもらいたいことの1つは、電力測定インフラストラクチャの構築を支援することです。これらの測定を行うためのツールを構築するのに役立ちます」とKanter氏は述べています。

MLPerf推論の結果の詳細なリストは、こちらから入手できます。

>>この記事はもともと姉妹サイトのEETimes。

埋め込み