EdgeAIがメモリテクノロジーに挑戦

エッジでのAIの台頭に伴い、メモリシステムに対する多くの新しい要件が発生します。今日のメモリテクノロジーは、この挑戦的な新しいアプリケーションの厳しい要求に応えることができますか?また、新しいメモリテクノロジーは、長期的にエッジAIに何を約束しますか?

最初に気付くのは、標準の「エッジAI」アプリケーションがないことです。その最も広い解釈のエッジは、クラウド外のすべてのAI対応電子システムをカバーしています。これには、一般的にエンタープライズデータセンターとオンプレミスサーバーを対象とする「ニアエッジ」が含まれる場合があります。

さらに、自動運転用のコンピュータービジョンなどのアプリケーションもあります。製造用ゲートウェイ機器は、AI推論を実行して、生産ライン上の製品の欠陥をチェックします。電柱の5G「エッジボックス」は、交通管理などのスマートシティアプリケーションのビデオストリームを分析します。また、5Gインフラストラクチャは、複雑でありながら効率的なビームフォーミングアルゴリズムのためにエッジでAIを使用しています。

「遠端」では、AIは携帯電話などのデバイスでサポートされています(Snapchatフィルターを考えてください)。結果を別のゲートウェイデバイスに送信する前にセンサーフュージョンを実行する工場のアプライアンスとIoTセンサーノードの音声制御。

ニューラルネットワークの重み、モデルコード、入力データ、中間アクティベーションを保存するためのエッジAIシステムでのメモリの役割は、ほとんどのAIアプリケーションで同じです。効率を維持するには、AIコンピューティングの容量を最大化するためにワークロードを高速化する必要があるため、容量と帯域幅に対する要求は一般的に高くなります。ただし、アプリケーション固有の要求は多種多様であり、サイズ、消費電力、低電圧動作、信頼性、熱/冷却の考慮事項、およびコストが含まれる場合があります。

エッジデータセンター

エッジデータセンターは主要なエッジ市場です。ユースケースは、医療画像、研究、複雑な金融アルゴリズムにまで及び、プライバシーがクラウドへのアップロードを妨げています。もう1つは自動運転車で、待ち時間によってそれが妨げられます。

これらのシステムは、他のアプリケーションのサーバーにあるのと同じメモリを使用します。

「AIアルゴリズムが開発およびトレーニングされているアプリケーションでは、高速のバイトレベルのメインメモリに低遅延DRAMを使用することが重要です」と、メモリ製品の設計者および開発者であるSmart ModularTechnologiesのソリューションアーキテクトであるPekonGuptaは述べています。 「大容量のデータセットには、大容量のRDIMMまたはLRDIMMが必要です。 NVDIMMは、システムの高速化に必要です。低速のSSDの代わりに、書き込みキャッシュとチェックポイントに使用します。」

Pekon Gupta

エンドユーザーの近くにコンピューティングノードを配置することは、電気通信事業者が採用しているアプローチです。

「これらの[telco]エッジサーバーが複雑なアルゴリズムを実行できるようにする傾向が見られます」とGupta氏は述べています。したがって、「サービスプロバイダーは、RDIMM、LRDIMM、NVDIMMなどの高可用性永続メモリなどのデバイスを使用して、これらのエッジサーバーにメモリと処理能力を追加しています。」

Guptaは、DRAMとFlashの間に特性を持つ同社の3D-Xpoint不揮発性メモリであるIntel Optaneを、サーバーAIアプリケーションの優れたソリューションと見なしています。

「OptaneDIMMとNVDIMMの両方がAIアクセラレーターとして使用されています」と彼は言いました。 「NVDIMMは、AIアプリケーションを高速化するために、非常に低遅延の階層化、キャッシング、書き込みバッファリング、およびメタデータストレージ機能を提供します。 OptaneデータセンターDIMMは、数百ギガバイトからテラバイトの永続メモリがDRAMと組み合わせて使用されるインメモリデータベースの高速化に使用されます。これらはどちらもAI / MLアクセラレーションアプリケーション向けの永続メモリソリューションですが、異なるユースケースがあります。」

IntelのOptaneの製品マーケティングディレクターであるKristieMannは、 EE Times に語りました。 OptaneはサーバーAIセグメントでアプリケーションを獲得しています。

IntelのKristieMann

「私たちの顧客は、今日すでにOptane永続メモリを使用してAIアプリケーションに電力を供給しています」と彼女は言いました。 「彼らは、eコマース、ビデオレコメンデーションエンジン、およびリアルタイムの財務分析の使用を成功裏に推進しています。利用可能な容量が増えたため、メモリ内アプリケーションへの移行が見られます。」

DRAMの高価格により、Optaneはますます魅力的な代替品になっています。 2つのIntelXeonスケーラブルプロセッサとOptane永続メモリを搭載したサーバーは、データを大量に消費するアプリケーション用に最大6テラバイトのメモリを保持できます。

「DRAMは依然として最も人気がありますが、コストと容量の観点からは制限があります」とMann氏は述べています。 「Optane永続メモリやOptaneSSDなどの新しいメモリおよびストレージテクノロジーは、コスト、容量、パフォーマンスの利点から、DRAMの代替として[登場]しています。 Optane SSDは、AIアプリケーションデータを継続的にフィードするためのHDDおよびNANDSSDデータをキャッシュする特に強力です。」

Optaneはまた、今日完全に成熟しておらず、スケーラブルではない他の新しい記憶と比べても遜色がない、と彼女は付け加えました。

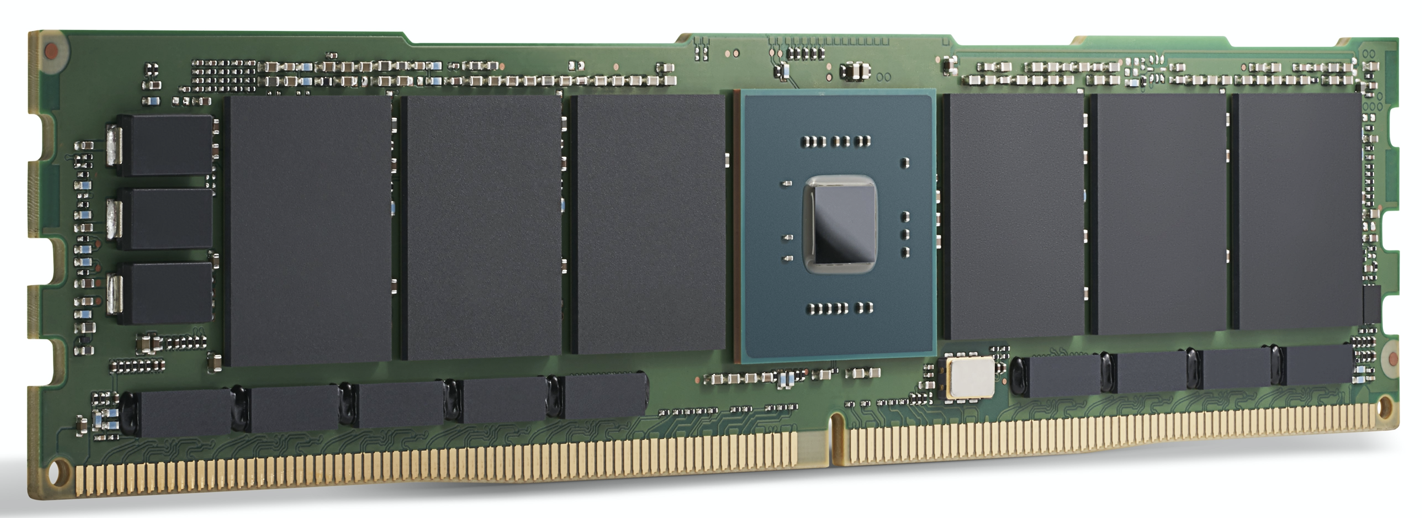

Intel Optane200シリーズモジュール。 Intelによると、Optaneは

今日AIアプリケーションに電力を供給するためにすでに使用されています。 (出典:Intel)

GPUアクセラレーション

ハイエンドのエッジデータセンターおよびエッジサーバーアプリケーションでは、GPUなどのAIコンピューティングアクセラレータが注目を集めています。ここでのメモリの選択肢には、DRAMだけでなく、高帯域幅GPUに給電するように設計された特別なDDR SDRAMであるGDDR、および複数のメモリダイをGPU自体と同じパッケージに配置する比較的新しいダイスタッキングテクノロジーであるHBMが含まれます。

どちらも、AIアプリケーションに必要な非常に高いメモリ帯域幅向けに設計されています。

最も要求の厳しいAIモデルのトレーニングでは、HBM2Eは3.6 Gbpsを提供し、460 GB / sのメモリ帯域幅を提供します(2つのHBM2Eスタックは1 TB / sに近い値を提供します)。これは、最小の領域で最小の消費電力で、利用可能な最高のパフォーマンスのメモリの1つです。 HBMは、GPUリーダーのNvidiaがすべてのデータセンター製品で使用しています。

ラムバスのIPコアの製品マーケティング担当シニアディレクターであるフランクフェロ氏は、GDDR6はエッジでのAI推論アプリケーションにも使用されていると述べています。フェロ氏によると、GDDR6は、エッジAI推論システムの速度、コスト、電力の要件を満たすことができます。たとえば、GDDR6は18 Gbpsを提供でき、72GB /秒を提供します。 4つのGDDR6DRAMを使用すると、300 GB / sに近いメモリ帯域幅が提供されます。

「GDDR6はAI推論およびADASアプリケーションに使用されます」とFerro氏は付け加えました。

Jetson AGGXavierからJetsonNanoまでのほとんどの非データセンターエッジソリューションに対するNvidiaのアプローチであるGDDR6とLPDDRを比較したとき、Ferroは、LPDDRがエッジまたはエンドポイントでの低コストのAI推論に適していることを認めました。

「LPDDRの帯域幅は、LPDDR4では4.2 Gbps、LPDDR5では6.4Gbpsに制限されています」と彼は言いました。 「メモリ帯域幅の需要が高まるにつれて、GDDR6を使用する設計の数が増えるでしょう。このメモリ帯域幅のギャップは、GDDR6の需要を促進するのに役立っています。」

ラムバスのフランクフェロ

GPUと一緒に収まるように設計されているにもかかわらず、他の処理アクセラレータはGDDRの帯域幅を利用できます。 Ferroは、推論といくつかのローエンドトレーニングに使用されるFPGAベースのAIアクセラレータであるAchronixSpeedster7tを強調しました。

「エッジAIアプリケーションにはHBMメモリとGDDRメモリの両方の余地があります」とFerro氏は述べています。 HBMは、「エッジアプリケーションで引き続き使用されます。 HBMのすべての利点については、3Dテクノロジーと2.5D製造により、コストは依然として高くなります。これを考えると、GDDR6は、特にネットワーク内のAI推論にとって、コストとパフォーマンスの間の適切なトレードオフです。」

HBMは、GraphcoreIPUなどの高性能データセンターAIASICで使用されます。優れたパフォーマンスを提供しますが、一部のアプリケーションでは価格が高額になる可能性があります。

Qualcommは、このアプローチを使用している企業の1つです。そのCloudAI 100は、エッジデータセンター、5G「エッジボックス」、ADAS /自動運転、および5GインフラストラクチャでのAI推論の加速を対象としています。

クアルコムのコンピューティングおよびエッジクラウドユニットのゼネラルマネージャーであるキースクレッシンは、次のように述べています。 「複数のサプライヤーから購入できる標準コンポーネントを使用したかったのです。すべてをオンチップで実行したいお客様と、クロスカードを使用したいお客様がいます。しかし、彼らは皆、コストを合理的に保ち、HBMやさらにエキゾチックな記憶を求めていませんでした。

「トレーニングでは、[複数のチップ]にまたがる非常に大きなモデルがありますが、推論[Cloud AI 100の市場]では、多くのモデルがよりローカライズされています。」

遠端

データセンターの外では、エッジAIシステムは一般に推論に重点を置いていますが、連合学習やその他の段階的なトレーニング手法など、いくつかの注目すべき例外があります。

電力に敏感なアプリケーション用の一部のAIアクセラレータは、AI処理にメモリを使用します。多次元行列の乗算に基づく推論は、計算の実行に使用されるメモリセルの配列を使用したアナログ計算技術に適しています。この手法を使用して、Syntiantのデバイスは家電製品の音声制御用に設計されており、Gyrfalconのデバイスはスマートフォンに設計されており、カメラ効果の推論を処理します。

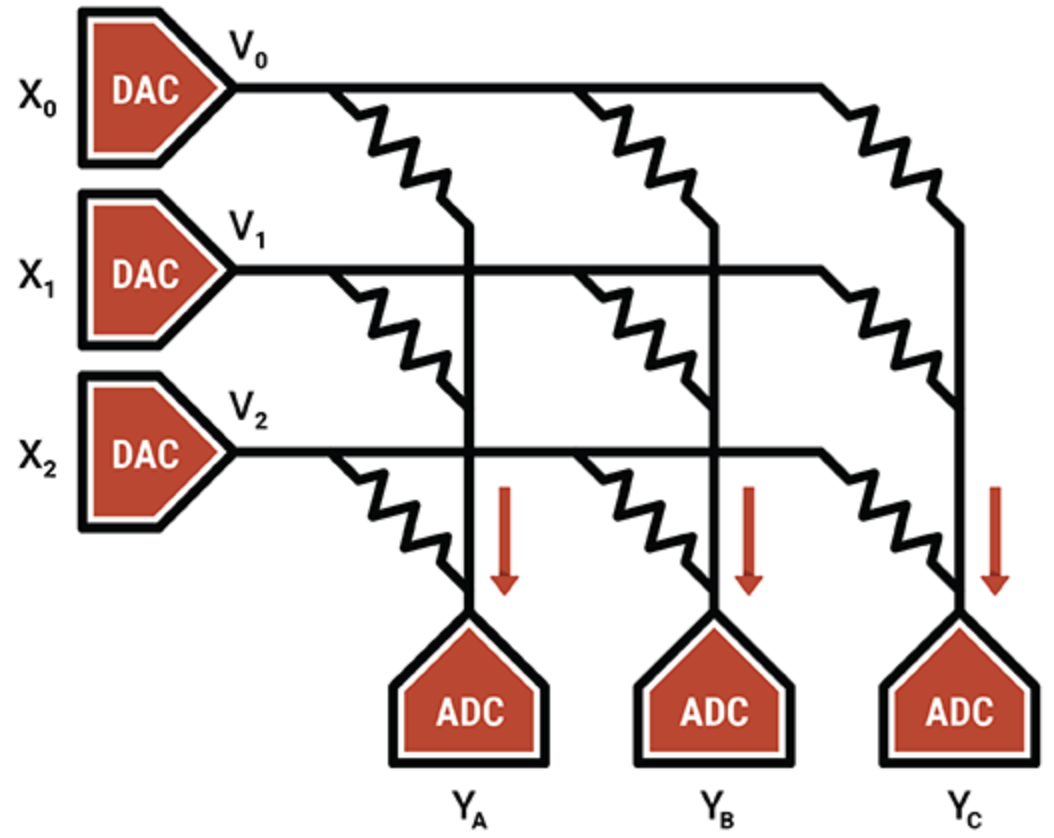

別の例では、インテリジェントプロセッシングユニットのスペシャリストであるMythicは、フラッシュメモリセルのアナログ操作を使用して、8ビット整数値(1つの重みパラメータ)を単一のフラッシュトランジスタに格納し、他のメモリ内計算テクノロジよりもはるかに高密度にします。プログラムされたフラッシュトランジスタは可変抵抗器として機能します。入力は電圧として供給され、出力は電流として収集されます。 ADCおよびDACと組み合わせると、効率的な行列乗算エンジンが得られます。

MythicのIPは、ノイズをキャンセルし、信頼性の高い8ビット計算を可能にする補正およびキャリブレーション技術にあります。

Mythicは、フラッシュメモリトランジスタのアレイを使用して、高密度の積和演算エンジンを作成します(出典:Mythic)

コンピューティングインメモリデバイスを除いて、ASICは特定のエッジニッチ、特に低電力および超低電力システムで人気があります。 ASIC用のメモリシステムは、いくつかのメモリタイプの組み合わせを使用します。分散ローカルSRAMは、最も高速で電力効率が高いですが、面積効率はそれほど高くありません。チップ上に単一のバルクSRAMを搭載すると、エリア効率が向上しますが、パフォーマンスのボトルネックが発生します。オフチップDRAMは安価ですが、はるかに多くの電力を使用します。

FlexLogixのCEOであるGeoffTate氏は、InferX X1の分散SRAM、バルクSRAM、およびオフチップDRAMの適切なバランスを見つけるには、さまざまなパフォーマンスシミュレーションが必要であると述べました。目的は、1ドルあたりの推論スループットを最大化することでした。これは、ダイサイズ、パッケージコスト、および使用されるDRAMの数の関数です。

「最適なポイントは、単一のx32 LPDDR4DRAMでした。 4K MAC(933MHzで7.5 TOPS);そして約10MBのSRAM」と彼は言った。 「SRAMは高速ですが、DRAMに比べて高価です。 TSMCの16nmプロセス技術を使用すると、1MBのSRAMは約1.1mm 2 かかります 。 「当社のInferXX1はわずか54mm 2 また、私たちのアーキテクチャにより、DRAMアクセスは計算と大部分が重複しているため、パフォーマンスを構成することはできません。単一のDRAMを備えた大型モデルの場合、少なくとも当社のアーキテクチャでは、適切なトレードオフになります」とTate氏は述べています。

Flex Logixチップは、低遅延のストリーミングビデオの分析など、リアルタイム操作を必要とするエッジAI推論アプリケーションで使用されます。これには、ADASシステム、セキュリティ映像の分析、医用画像処理、品質保証/検査アプリケーションが含まれます。

これらのアプリケーションでは、InferX X1と一緒にどのような種類のDRAMが搭載されますか?

「LPDDRが最も人気があると思います。1つのDRAMが10GB /秒以上の帯域幅を提供しますが、重み/中間アクティベーションを保存するのに十分なビットがあります」とTate氏は述べています。 「他のDRAMには、より多くのチップとインターフェイスが必要であり、使用されていないビットをより多く購入する必要があります。」

ここに新しいメモリテクノロジーの余地はありますか?

「新しいメモリを使用するとウェーハのコストが劇的に上昇しますが、SRAMはシリコン領域を除いて「無料」です」と彼は付け加えました。 「経済が変化するにつれて、転換点も変化する可能性がありますが、それはさらに先のことになるでしょう。」

新たな思い出

規模の経済にもかかわらず、他の種類のメモリはAIアプリケーションの将来の可能性を秘めています。

MRAM(磁気抵抗RAM)は、印加された電圧によって制御される磁石の向きを介して、データの各ビットを格納します。電圧がビットを反転させるのに必要な電圧よりも低い場合、ビットが反転する可能性があります。このランダム性は望ましくないため、MRAMはそれを防ぐためにより高い電圧で駆動されます。それでも、一部のAIアプリケーションは、この固有の確率を利用できます(これは、データをランダムに選択または生成するプロセスと考えることができます)。

実験では、MRAMの確率機能をGyrfalconのデバイスに適用しました。これは、すべての重みとアクティベーションの精度を1ビットに下げる手法です。これは、ファーエッジアプリケーションのコンピューティングと電力の要件を大幅に削減するために使用されます。ネットワークの再トレーニング方法によっては、精度とのトレードオフが発生する可能性があります。一般に、ニューラルネットワークは、精度が低下しても確実に機能するようにすることができます。

「2値化されたニューラルネットワークは、-1または+1の数の確実性が低下しても、確実に機能できるという点で独特です」と、SpinMemoryの製品副社長であるAndyWalkerは述べています。 「このようなBNNは、誤って書き込まれたメモリビットのいわゆる「ビットエラーレート」を導入することでこの確実性が低下するため、高レベルの精度で機能できることがわかりました。」

スピンメモリーのアンディウォーカー

MRAMは、低電圧レベルで制御された方法でビットエラーレートを自然に導入し、精度を維持しながら電力要件をさらに下げることができます。重要なのは、最低電圧と最短時間で最適な精度を決定することです。ウォーカー氏によると、これは最高のエネルギー効率につながります。

この手法はより高精度のニューラルネットワークにも適用されますが、MRAMセルにはBNNのバイナリ状態と一致する2つの状態があるため、BNNに特に適しています。

ウォーカー氏によると、エッジでMRAMを使用することは、もう1つの潜在的なアプリケーションです。

「エッジAIの場合、MRAMは、高性能の精度が要求されないアプリケーションで低電圧で動作する機能を備えていますが、エネルギー効率とメモリ耐久性の向上は非常に重要です」と彼は言いました。 「さらに、MRAMの固有の非揮発性により、電力なしでデータを保存できます。

1つのアプリケーションは、いわゆるユニファイドメモリであり、「この新しいメモリは、組み込みフラッシュとSRAMの代替として機能し、ダイの領域を節約し、SRAMに固有の静的消費電力を回避できます。」

Spin MemoryのMRAMは商業的に採用される寸前ですが、BNNの特定の実装は、基本的なMRAMセルのバリアントで最適に機能します。したがって、それは研究段階にとどまります。

ニューロモルフィックReRAM

エッジAIアプリケーション用のもう1つの新しいメモリは、ReRAMです。 Weebit Nanoの酸化ケイ素(SiOx)ReRAMテクノロジーを使用したミラノ工科大学による最近の研究は、ニューロモルフィックコンピューティングの可能性を示しました。 ReRAMは、ニューラルネットワークハードウェアに可塑性の次元を追加しました。つまり、条件の変化に応じて進化する可能性があります。これは、ニューロモルフィックコンピューティングで役立つ品質です。

現在のニューラルネットワークは、訓練されたタスクを忘れずに学習することはできませんが、脳はこれを非常に簡単に行うことができます。 AIの用語では、これは「教師なし学習」であり、アルゴリズムがラベルのないデータセットに対して推論を実行し、データ内の独自のパターンを探します。最終的には、新しいタスクをその場で学習し、周囲の環境に適応できるReRAM対応のエッジAIシステムになる可能性があります。

全体として、メモリメーカーは、AIアプリケーションに必要な速度と帯域幅を提供するテクノロジーを導入しています。 AIコンピューティングと同じチップ上、同じパッケージ内、または別々のモジュール上にあるかどうかにかかわらず、さまざまなメモリを利用して、多くのエッジAIアプリケーションに適合させることができます。

エッジAIのメモリシステムの正確な性質はアプリケーションによって異なりますが、GDDR、HBM、Optaneはデータセンターで人気があり、LPDDRはエンドポイントアプリケーションのオンチップSRAMと競合しています。

新たな記憶は、ニューラルネットワークを今日のハードウェアの能力を超えて進歩させ、将来の電力効率の高い脳に触発されたシステムを可能にするように設計された研究に、その斬新な特性を貸し出しています。

>>この記事はもともと姉妹サイトのEETimes。

埋め込み